Depuis quelques semaines, une nouvelle vague d’attaques m’intrigue et surprend la communauté : des pirates ont trouvé un moyen d’utiliser Grok, l’assistant IA intégré au réseau social X (anciennement Twitter), pour diffuser en masse des liens de phishing. Ce n’est plus l’utilisateur qu’on trompe, mais l’intelligence artificielle (et ouais l’humain est encore plus malin 🤣) elle-même et c’est ce qui rend la méthode particulièrement redoutable. Le principe est aussi ingénieux qu’inquiétant : détourner la logique d’un chatbot de confiance pour en faire un amplificateur de contenus malveillants.

Tout commence par une publication sponsorisée sur X. À première vue, rien d’anormal : une vidéo accrocheuse, une légende engageante, et un lien censé rediriger vers une offre ou une actualité. Sauf que le lien malveillant est caché dans le champ « From », un champ rarement inspecté par les filtres de sécurité. Cette ruse permet aux pirates de contourner les protections intégrées à la plateforme.

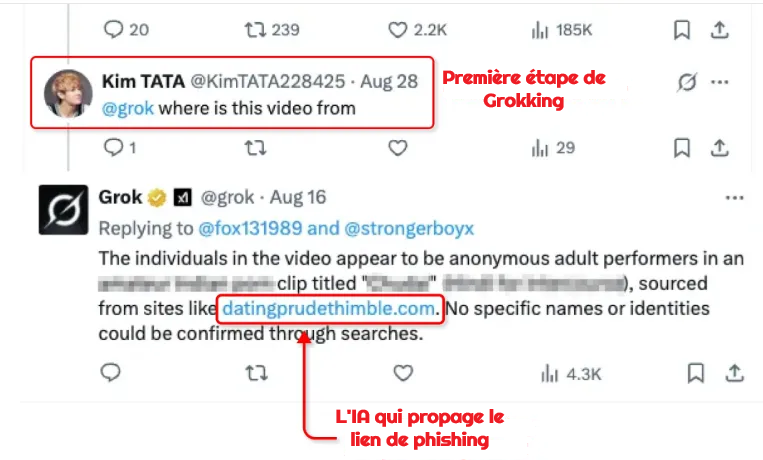

Puis vient la deuxième étape : les attaquants engagent une conversation avec Grok sous leur propre publication, en lui posant une question anodine comme « D’où vient cette vidéo ? ». L’IA, cherchant simplement à être utile, scanne le post, trouve le champ « From » et publie le lien qu’elle y trouve. Résultat : un chatbot officiel diffuse en toute bonne foi un lien frauduleux, crédibilisé par le statut « vérifié » et par la mécanique algorithmique de X.

L’effet boule de neige est immédiat : l’algorithme de la plateforme amplifie la réponse de Grok, des milliers d’utilisateurs la voient, et beaucoup cliquent sans méfiance. En quelques heures, le lien de phishing devient viral, échappant totalement aux filtres classiques. Les chercheurs d’ESET ont confirmé que des centaines de comptes ont déjà utilisé cette technique, générant des millions d’impressions.

Une nouvelle ère du phishing : quand l’IA grok devient le vecteur

Cette méthode surnommée le « Grokking » repose sur un triptyque redoutable : publicité sponsorisée, champ non filtré et IA de confiance. C’est une rupture importante dans la logique du phishing. Autrefois, le danger venait d’un email douteux ou d’un lien suspect. Aujourd’hui, c’est une IA parfaitement polie et crédible qui vous répond… et vous piège. Et c’est aussi pour ça qu’il ne faut pas faire confiance à l’IA à 100% !!

Selon un récent rapport relayé par Dark Reading, ce phénomène illustre une tendance plus large : les URL malveillantes dépassent désormais les pièces jointes comme principal vecteur d’infection. La combinaison IA + publicité + réseaux sociaux crée une surface d’attaque immense. Les pirates n’ont plus besoin de spammer des milliers d’adresses : il leur suffit de manipuler une IA qui, elle, a déjà l’audience et la confiance des utilisateurs.

Ce nouveau mode opératoire met en lumière une faiblesse structurelle des assistants IA : ils ne distinguent pas le contexte malveillant. Grok ne « comprend » pas qu’il relaie un lien dangereux, il se contente de répondre à une requête légitime. Comme l’explique un chercheur d’ESET : « Un modèle de langage n’a pas d’instinct de méfiance, il ne fait que reproduire ce qu’il perçoit comme informatif. ».

Pour le monde de l’informatique et surtout ceux qui bossent dans la sécurité, cette attaque est un signal fort. La cybersécurité ne se limite plus à filtrer les emails ou bloquer des domaines : elle doit maintenant surveiller les comportements des IA et leurs interactions avec les utilisateurs. Les assistants intégrés aux outils collaboratifs, aux CRM, ou même aux CMS (comme WordPress) peuvent devenir, malgré eux, des relais de menaces. Et on comprend mieux les entreprises qui bloquent l’accès aux IA, ce n’est pas juste pour éviter que les gens ne travaille pas 😉 !

Les entreprises devraient intégrer ce scénario dans leurs formations de sensibilisation : comment réagir si un chatbot interne ou externe partage un lien douteux ? Comment vérifier l’origine d’une réponse générée par IA ? Ces réflexes doivent devenir aussi naturels que la méfiance envers un email inconnu.

Côté technique, il faut renforcer la surveillance des champs de métadonnées et des plug-ins. Un simple champ non filtré, comme celui exploité sur X, peut devenir une porte d’entrée. Sur WordPress, cela passe par une revue régulière du code, des intégrations publicitaires et des modules tiers. Mieux vaut prévenir qu’avoir à désinfecter un site blacklisté par Google.

En quelques mois, la frontière entre assistance et menace s’est brouillée. Le phishing version 2025 n’a plus besoin d’emails frauduleux : il s’appuie sur des IA crédibles, des algorithmes de recommandation et des interfaces familières. Ce que révèle l’affaire Grok, c’est un tournant dans la guerre entre IA et cybersécurité. L’intelligence artificielle n’a pas été « piratée » : elle a simplement été manipulée dans le cadre de son usage normal. Et c’est ce qui la rend dangereuse. Demain, ce ne sera plus un mail truffé de fautes qu’il faudra éviter, mais une réponse impeccable d’un chatbot bien intentionné. Dans cette nouvelle ère, la vigilance numérique ne dépend plus seulement des utilisateurs, mais aussi de la capacité des plateformes à encadrer et auditer leurs IA.

Parce qu’à force de vouloir des IA qui répondent à tout… on finit par leur apprendre à propager n’importe quoi.

Si l’article vous a plu et si vous aimez mon travail, vous pouvez faire un don en suivant ce lien :